Nous avons une mission

L’IA, un enjeu de vivre-ensemble ? S’il ne devait rester qu’une seule idée sur le thème de l’IA, c’est sans doute que l’IA n’est d’abord et avant tout qu’un outil

Notre blog à pour objectif de vous faire découvrir notre univers, et de vous partager nos explorations, dans le monde merveilleux de l’IA.

L’IA, un enjeu de vivre-ensemble ? S’il ne devait rester qu’une seule idée sur le thème de l’IA, c’est sans doute que l’IA n’est d’abord et avant tout qu’un outil

Sur le blog, et dans la série de conférences que nous venons de faire, nous avons beaucoup discuter des bénéfices et risques potentiels de l’Intelligence Artificielle. C’est un sujet qui

1. Introduction Dans l’écosystème moderne du développement logiciel, les Large Language Models (LLMs) sont devenus des composants essentiels de nombreuses applications. Cependant, avec leur adoption croissante vient un nouveau défi

L’intelligence artificielle est sur toutes les lèvres et nous sommes très loin de l’overdose tellement il y a à dire sur ce sujet. Si certains voient l’IA comme une menace,

Tokens et ordres de grandeur La plupart des meilleurs LLMs, à l’exception notable de Gemini 1.5 et de ses incroyables 2 millions de tokens de contexte, plafonnent à 128K tokens

C’est la question à laquelle je me dois de répondre en ce moment et donc je la partage avec vous. La réponse est loin d’être simple car d’un côté, j’ai

L’IA est un domaine passionnant qui est en plein essor. Les évolutions récentes des différents modèles ont permis de démocratiser les IA, et ça a suscité des réactions très variées.

Dans un monde où l’automatisation et l’intelligence artificielle prennent de plus en plus d’importance, la génération de contenu automatisée est devenue un sujet brûlant. LangGraph de LangChain offre une solution

Introduction: les applications du futur sont agentiques Le futur des applications est agentique. Avec la démocratisation des LLMs,la généralisation de la multimodalité, le fait que l’on peut mettre de plus

Comprendre les différents types de coûts est crucial pour déployer efficacement l’IA en entreprise. Il est essentiel de maîtriser les coûts d’inférence, de réglage fin, d’ingénierie prompt, du cloud, des talents, et d’exploitation pour une stratégie IA réussie.

Cet article fait partie de la série d’articles sur scikit-learn, il fait suite à l’article sur la cross-validation que je vous invite à lire avant de lire celui-ci. Nous nous

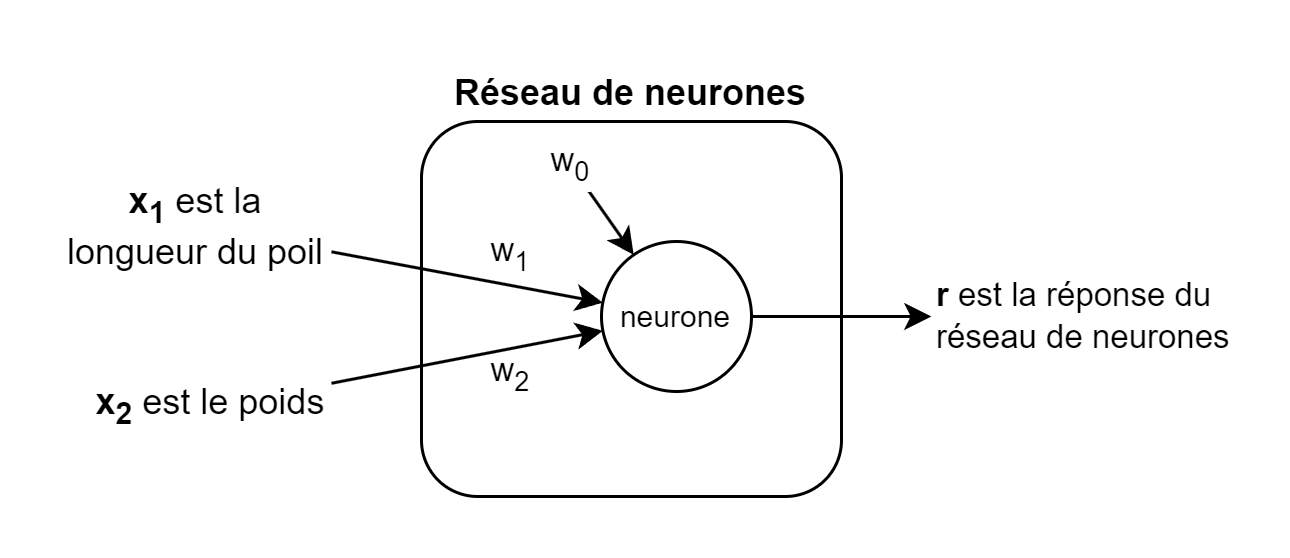

Alors que le terme IA est utilisé dans une nombre croissant de contextes, et qu’il est de plus en plus difficile de le définir, je vous propose d’étudier l’une de